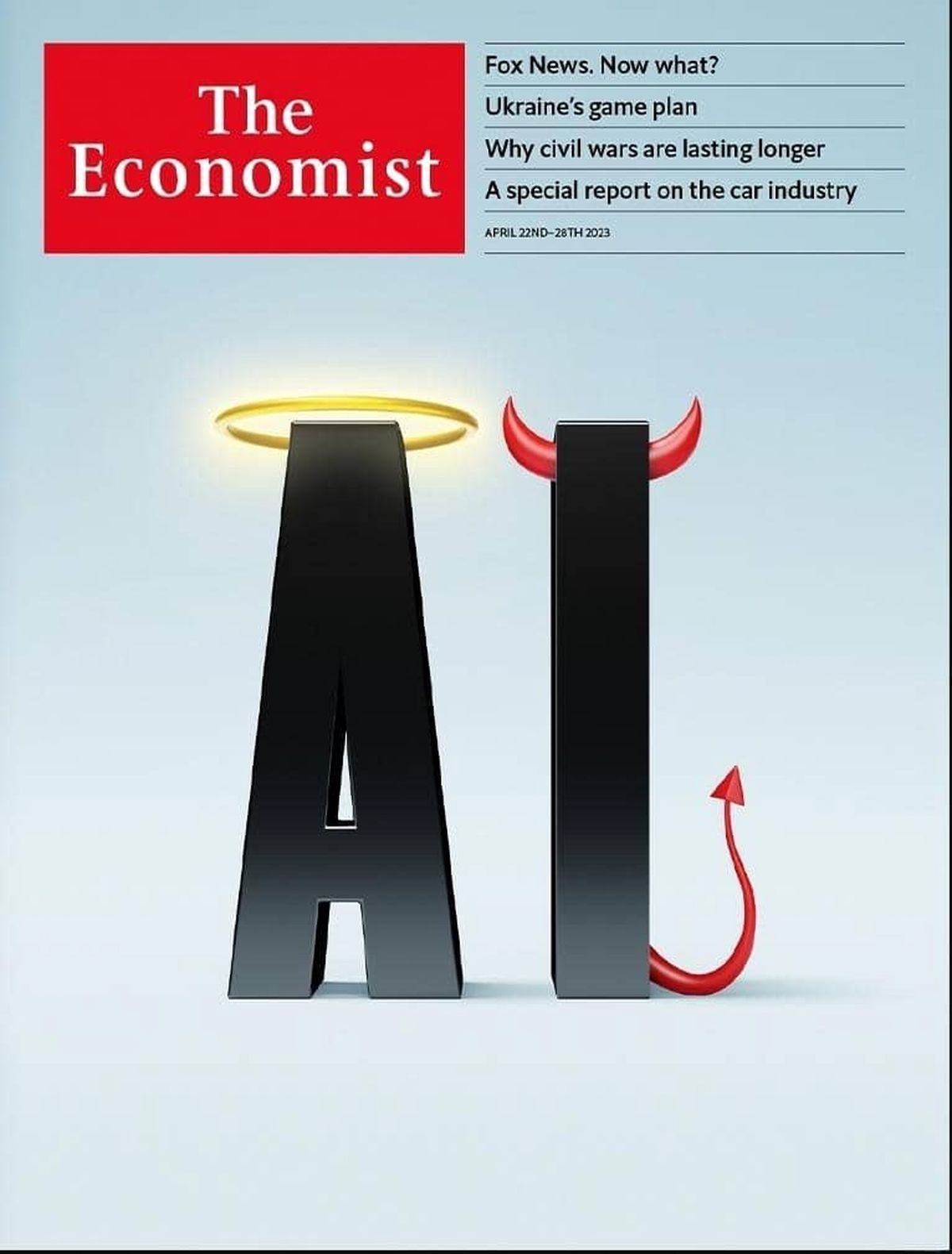

تمام ابعاد مثبت و شیطانی هوش مصنوعی؛ چقدر باید نگران بود؟

اقتصاد۲۴- در سر مقاله شماره ۲۲ آپریل سال ۲۰۲۳ آمده است که هوش مصنوعی نه تنها مشاغل، دقت حقایق و آبرو و اعتبار را تهدید میکند بلکه وجود بشریت را نیز تهدید کرده و همین باعث درخواست برای توقف توسعهی این فناوری شده است، اما آیا محققان بیش از حد واکنش نشان دادهاند؟

«آیا باید تمامی مشاغل، از جمله مشاغل رضایت بخش خود را ماشینی کنیم؟ آیا باید ذهنهای غیرانسانی را پرورش دهیم که ممکن است تعدادشان از ما پیشی بگیرد، هوشمندتر از ما شوند و در نهایت جایگزین ما شوند؟ آیا باید خطر از دست دادن کنترل تمدن خود را به جان بخریم؟»

این سؤالات ماه گذشته در نامهای سرگشاده توسط مؤسسه آینده زندگی Future of Life Institute مطرح شد. این نامه خواستار یک «توقف» شش ماهه در پروژههای فوق پیشرفته هوش مصنوعی شده و توسط بزرگان فناوری از جمله ایلان ماسک امضا شد. این برجستهترین نمونه تاکنون است که نشان میدهد چگونه پیشرفت سریع در هوش مصنوعی باعث ایجاد نگرانی در مورد خطرات بالقوه این فناوری شده است.

یک سناریوی مرگبار

اخیرا چت جی پی تی که یک چت بات مدل زبانی بزرگ (llms) است و توسط شرکت OpenAI توسعه یافته است، حتی سازندگان خود را با استعداد غیرمنتظره اش غافلگیر کرده است. این تواناییهای نوظهوری شامل همه چیز میشود. از حل پازلهای منطقی و نوشتن کدهای کامپیوتری گرفته تا شناسایی فیلمها از روی خلاصه داستانها که با اموجی ((Emoji نوشته شده اند.

این مدلها میتوانند رابطه انسانها با رایانه، دانش و حتی با خودشان را تغییر دهند. طرفداران هوش مصنوعی درباره پتانسیل آن برای حل مشکلات بزرگ با توسعه داروهای جدید، طراحی مواد جدید برای کمک به مبارزه با تغییرات جوی یا از بین بردن پیچیدگیهای انرژی همجوشی بحث میکنند. اما برای دیگران، این واقعیت که قابلیتهای هوش مصنوعی در حال پیشی گرفتن از درک سازندگانش است، یک سناریوی علمی-تخیلی را که در آن یک ماشین از مخترع خود پیشی میگیرد و اغلب با عواقب مرگبار همراه است، زنده میکند.

ترکیبی جوشان از هیجان و ترس

این ترکیب جوشان از هیجان و ترس، سنجش فرصتها و خطرات را دشوار میکند. اما میتوان از سایر صنایع و از تغییرات فناوری گذشته درس گرفت. پس چه چیزی تغییر کرده است که هوش مصنوعی را بسیار توانمندتر کرده است؟ چقدر باید ترسید؟ و دولتها چه باید بکنند؟

اکونومیست در این قسمت به بررسی مدلهای زبانی بزرگ و آیندهی آن پرداخته است.

موج اول سیستمهای هوش مصنوعی مدرن، که یک دهه پیش پدیدار شد، بر روی دادههای آموزشی با برچسبگذاری دقیق تکیه داشت. هنگامی که در معرض تعداد کافی نمونه برچسبگذاری شده قرار میگیرند، میتوانند کارهایی مانند تشخیص تصاویر یا رونویسی گفتار را بیاموزند. سیستمهای امروزی نیازی به برچسبگذاری اولیه ندارند و در نتیجه میتوان با استفاده از مجموعه دادههای بسیار بزرگتری که از منابع آنلاین گرفته شدهاند، آموزش ببینند. مدلهای زبانی بزرگ در واقع میتواند در کل اینترنت آموزش ببینند - که تواناییهای خوب و بد آنها را توضیح میدهد.

بیشتر بخوانید: اظهارات وزیر ارتباطات درباره قطعی اینترنت در سال گذشته

زمانی که چت جی پی تی در نوامبر منتشر شد، این قابلیتها برای عموم مردم آشکار شد. یک میلیون نفر در عرض یک هفته از آن استفاده کردند وسپس ۱۰۰ میلیون نفر در عرض دو ماه. بعد هم به سرعت از آن برای تولید انشاهای مدرسه و سخنرانیهای عروسی استفاده شد. محبوبیت چت جی پی تی و اقدام مایکروسافت برای گنجاندن آن دربینگ، موتور جستجوی خود، شرکتهای رقیب را بر آن داشت تا آنها نیز چت باتهای خود را منتشر کنند.

تهدیدی برای بشریت؟

برخی از این موارد نتایج عجیبی به همراه داشت. چت بات بینگ (Bing Chat) به یک روزنامه نگار پیشنهاد کرد که همسرش را ترک کند. چت جی پی تی توسط یک استاد حقوق به افترا متهم شده است. مدلهای زبانی بزرگ، پاسخهایی را ارائه میکند که ظاهرا حقیقت دارد، اما اغلب حاوی اشتباهات واقعی یا جعل هستند. با این حال، مایکروسافت، گوگل و سایر شرکتهای فناوری شروع به استفاده از llms در محصولات خود کردهاند تا به کاربران در ایجاد اسناد و انجام کارهای دیگر کمک کنند.

شتاب اخیر در قدرت و دید سیستمهای هوش مصنوعی و افزایش آگاهی از تواناییها و نقصهای آنها، این نگرانی را ایجاد کرده است که این فناوری اکنون به سرعت در حال پیشرفت است که نمیتوان آن را به طور ایمن کنترل کرد. از این رو فراخوان برای توقف و نگرانی فزاینده برای این است که هوش مصنوعی میتواند نه تنها مشاغل، صحت مطالب و آبرو واعتبار، بلکه موجودیت خود بشریت را نیز تهدید کند.

انقراض؟ شورش؟

ترس از اینکه ماشینها مشاغل را بدزدند، به قرنها پیش بر میگردد. اما تاکنون فناوری جدید، مشاغل جدیدی را برای جایگزینی مشاغلی که ویران کرده، ایجاد کرده است. اما آیا ممکن است که این بار متفاوت باشد؟ جابجایی ناگهانی در بازار کار را نمیتوان رد کرد، حتی اگر تا کنون هیچ نشانهای از آن وجود نداشته باشد. فناوریهای قبلی جایگزین کارهای غیر ماهر شده بود، اما llms میتواند برخی از کارهای کارگران یقه سفید (کارکنانی که پشت میز کار میکنند)، مانند خلاصه کردن اسناد و نوشتن کد را انجام دهد.

درجه خطر هوش مصنوعی به شدت مورد بحث قرار گرفته است. کارشناسان به گروههای مختلف نقسیم شده اند. در یک نظرسنجی از محققان هوش مصنوعی که در سال ۲۰۲۲ انجام شد، ۴۸ ٪ فکر کردند که حداقل ۱۰ ٪ احتمال دارد که تاثیر هوش مصنوعی "بسیار بد (مثلاً انقراض انسان) " باشد. اما ۲۵ ٪ گفتند که خطر ۰ ٪ است. بقیه ریسک را ۵ درصد اعلام کردند. کابوس این است که یک هوش مصنوعی پیشرفته میتواند با ساختن سم یا ویروس یا ترغیب انسان به انجام اقدامات تروریستی باعث آسیب در مقیاس گسترده میشود. محققان نگرانند که اهداف آینده هوش مصنوعی ممکن است با اهداف خالقان آنها همسو نباشد.

این سناریوها را نباید نادیده گرفت. اما همه اینها شامل مقدار زیادی حدس و گمان است. همچنین برخی در مورد خطرات هوش مصنوعی اغراق میکنند. اعمال مقررات سنگین، یا یک توقف، امروز واکنشی بیش از حد به نظر میرسد. توقف نیز غیرقابل اجرا خواهد بود.

مقررات لازم است، اما به دلایل پیش پا افتادهتر از نجات بشریت. سیستمهای هوش مصنوعی موجود نگرانیهای واقعی را در مورد سوگیری، حریم خصوصی و حقوق مالکیت معنوی ایجاد میکند. با پیشرفت فناوری، مشکلات دیگری نیز ممکن است آشکار شوند. نکته کلیدی این است که بین وعده هوش مصنوعی و ارزیابی خطرات تعادل برقرار کنید و برای سازگاری با آن آماده باشید.

رویکرد دولتها به هوش مصنوعی

تاکنون دولتها سه رویکرد متفاوت را در پیش گرفته اند. در یک انتهای این طیف بریتانیا قرار دارد که به قوانین یا نهادهای نظارتی جدیدی نیست، اما مقررات موجود را برای سیستمهای هوش مصنوعی اعمال میکند. هدف افزایش سرمایه گذاری و تبدیل بریتانیا به یک "ابرقدرت هوش مصنوعی" است. آمریکا نیز رویکرد مشابهی را در پیش گرفته است، اگرچه دولت بایدن اکنون درباره تعیین قوانین سیستمهای هوش مصنوعی نظرات عموم کاربران را درخواست کرده است.

اتحادیه اروپا موضع سختگیرانه تری اتخاذ میکند. قانون پیشنهادی آن، استفادههای مختلف از هوش مصنوعی را بر اساس درجه ریسک طبقهبندی میکند وهرچه درجه خطر افزایش یابد به نظارت سخت تری نیاز دارد. برخی از کاربردهای هوش مصنوعی به طور کلی ممنوع هستند، مانند شناسایی بایومتریک از راه دور. شرکتهایی که قوانین را زیر پا بگذارند جریمه خواهند شد. برای برخی از منتقدان، این مقررات را خفه کننده میدانند.

رویکرد چین در قبال هوش مصنوعی؛ مطابقت با ارزشهای سوسیالیستی

گروه سوم معتقدند که حتی رویکرد سخت گیرانه تری لازم است. دولتها باید با هوش مصنوعی مانند داروها رفتار کنند. یعنی آزمایشهای دقیق و تأیید اولیه قبل از انتشار عمومی. چین برخی از این کارها را انجام میدهد و شرکتها را ملزم میکند تا محصولات هوش مصنوعی را ثبت کنند و قبل از عرضه، بازبینی امنیتی را انجام دهند. اما در حقیقت هدف از این نظارت فقط امنیت نیست. یک شرط کلیدی درچین این است که محتوای هوش مصنوعی باید با ارزشهای اساسی سوسیالیستی مطابقت داشته باشد.

چه باید کرد؟

چه باید کرد؟ بعید است که رویکردی مثل رویکرد بریتانیا، کافی باشد. اگر هوش مصنوعی به اندازه ماشینها، هواپیماها و داروها یک فناوری مهم باشد – که دلایل خوبی برای پذیرش آن وجود دارد - پس مانند آنها به قوانین جدیدی نیاز دارد. بر این اساس، مدل اتحادیه اروپا نزدیکترین مدل به هدف است، اگرچه سیستم طبقهبندی آن بیش از حد پیچیده است و رویکرد مبتنی بر اصول انعطافپذیرتر خواهد بود. افشای قانع کننده در مورد نحوه آموزش سیستم ها، نحوه عملکرد و نحوه نظارت آنها و نیاز به بازرسی، با قوانین مشابه در سایر صنایع نیز قابل استفاده خواهد بود.

این میتواند در صورت نیاز، مقررات سخت گیرانه تری را در طول زمان فراهم کند. همچنین ممکن است معاهدات بیندولتی در صورت بروز شواهد خطر ایجاد شوند؛ مشابه پیمانهای بر تسلیحات هستهای. برای نظارت بر این خطر، دولتها میتوانند زمانی که شرکتها انگیزهای برای سرمایهگذاری به دراین حوزهها ندارند، بدنهای را با الگوبرداری از سرن (سازمان اروپایی پژوهشهای هستهای که بزرگترین آزمایشگاه فیزیک ذرهای در جهان است و بیست کشور اروپایی عضو آن هستند) تشکیل دهند که میتواند درباره هوش مصنوعی مطالعه کند.

این فناوری قدرتمند خطرات جدیدی را ایجاد میکند، اما فرصتهای خارق العادهای را نیز ارائه میدهد. متعادل کردن این دو به معنای گام برداشتن با دقت است. یک رویکرد سنجیده امروزی میتواند پایههایی را فراهم کند که قوانین بیشتری را میتوان در آینده اضافه کرد. اما زمان شروع ساخت آن پایهها اکنون فرا رسیده است.

منبع: اکوایران