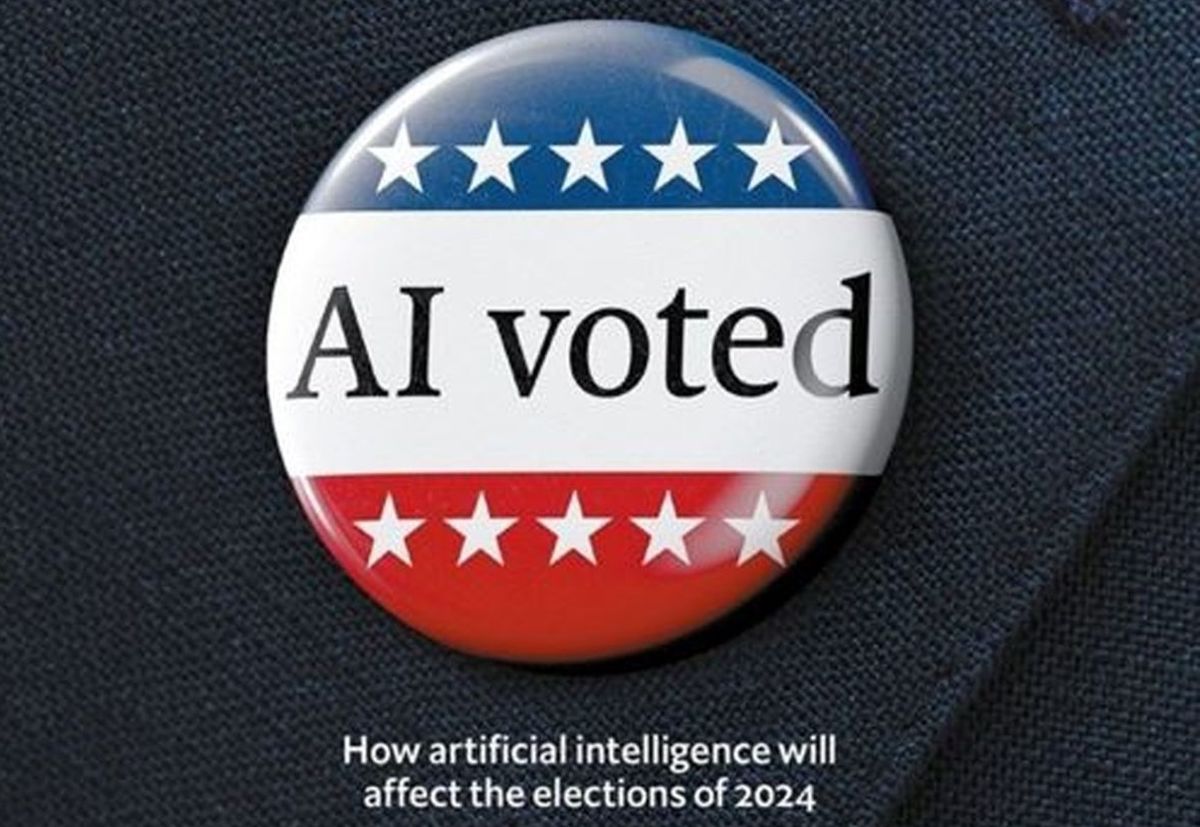

هوش مصنوعی چه تاثیری بر انتخابات آینده دارد؟!

اقتصاد۲۴- موضوع اصلی سیاست از همان ابتدا متقاعد کردن بوده؛ با این حال همواره پروپاگاندا و تبلیغات هم در کمین سیاست بوده است. کمپینهای تبلیغاتی بدبینی را ترویج میدهند، در مسایل و مشکلات موجود اغراق میکنند و دروغ میگویند و در عین حال این دروغها را از هر راه ممکن منتقل میکنند. توطئههای ضد واکسن زمانی به جای پادکست از طریق جزوههای مختلف تبلیغ میشد.

حتی در این راستا ضدماسکها یک قرن قبل از کرونا هم مشغول بودند و در دوران آنفولانزای اسپانیایی یک کمپین اطلاعات نادرست به راه انداخته بودند. در آن زمان آنها این اطلاعات نادرست و پیامهای جعلی درباره پزشکی را از طریق تلگرام (در واقع از طریق سیمها نه اپلیکیشنهای گوشیهای هوشمند) ارسال میکردند. این در مورد انتخابات هم مصداق دارد. در حقیقت، چون مردم فرشته نیستند، انتخابات هیچ گاه عاری از باطل و باورهای غلط نبوده است.

اما از آنجایی که جهان در سال ۲۰۲۴ چند انتخابات مهم خواهد داشت، یک پدیده جدید باعث نگرانیهای بسیاری شده است. در گذشته، اطلاعات نادرست و جعلی را همیشه انسانها تولید میکردند. اما به تازگی پیشرفتهای حوزه هوش مصنوعی تبلیغات مصنوعی را نیز ممکن کرده است. از آنجایی که یک سری از کشورهایی مانند آمریکا، بریتانیا، هند، اندونزی، مکزیک و تایوان که جمعیت مجموعشان بالغ بر حدود ۴ میلیارد نفر است در سال ۲۰۲۴ رایگیریهایی خواهند داشت؛ این ترس در میان ناظران شدت گرفته که ممکن است در سال ۲۰۲۴ شاهد افزایش و شدت گرفتن کمپینهای اطلاعات نادرست باشیم. اما آیا شهروندان خود این کشورها هم باید نگران این موضوع باشند؟

مهم است که در مورد چیزهایی که ابزارهای مولد هوش مصنوعی مانند چتجیپیتی انجام میدهند- و البته چیزهایی که تغییر نمیدهند- دقیق فکر کنیم. پیش از آمدن این ابزارها اطلاعات نادرست یکی از مشکلات بزرگ دموکراسیها بود. اصلأ ایده مخرب تقلب در انتخابات ریاست جمهوری آمریکا در سال ۲۰۲۰ بود که باعث شد آشوبگران در ششم ژانویه به ساختمان کنگره هجوم آورند. اما فراموش نکنید که انتشار این ایده را دونالد ترامپ و دیگر بزرگان جمهوریخواه و رسانههای گروهی محافظهکار با استفاده از ابزارهای متعارف آغاز کردند. فعالان حزب حاکم هند هم در این بین شایعات خود را از طریق تاپیکهای واتساپ منتشر کردند. همچنین مبلغان حزب کمونیست چین نیز از طریق رسانههای خبری به ظاهر مشروع، منظور خود را به تایوانیها منتقل کردند. همه اینها بدون استفاده از ابزارهای مولد هوش مصنوعی انجام شد.

بیشتر بخوانید:زندگی هوشمندتر با فناوری محاسبات محیطی الجی

در این وضعیت مدلهای هوش مصنوعی چه چیزی را میتوانند در سال ۲۰۲۴ تغییر دهند؟ یکی از این چیزها کمیت اطلاعات نادرست است: اگر حجم مطالب بیهوده و جعلی در ۱۰۰۰ یا ۱۰۰۰۰۰ ضرب شود، ممکن است مردم متقاعد شوند که رأی خود را تغییر دهند. مورد دوم مربوط به کیفیت است. دیپفیکهای بیش از حد واقعی میتوانند رایدهندگان را قبل از اینکه صدا، عکسها و ویدیوهای نادرست حذف شوند، تحت تأثیر قرار دهد. سومین هدف، هدفگذاریهای کوچک است. هوش مصنوعی میتواند رایدهندگان را غرق در تبلیغاتی کند که در مقیاس بسیار زیادی شخصی شدهاند. شناسایی شبکههای رباتهای تبلیغاتی سختتر از تلاشهای موجود برای انتشار اطلاعات نادرست است. از آنجا که مردم عادت کردهاند به همه چیز شک کنند، این موضوع اعتماد رایدهندگان به هموطنان خود را نیز- که در آمریکا برای دهههای متوالی رو به کاهش بوده- ممکن است آسیب بزند.

این نکات اگر چه نگرانکنندهاند، اما دلایلی وجود دارد که باور کنیم هوش مصنوعی قرار نیست تجربیات ۲۵۰۰ ساله بشریت در زمینه دموکراسی را از بین ببرد. بسیاری از مردم فکر میکنند که دیگران از خودشان سادهلوحترند. در واقع، متقاعد کردن رایدهندگان به خصوص در مورد موضوعات مهم سیاسی از قبیل انتخاب رئیسجمهور دشوار است (از خودتان بپرسید چه دیپفیکی میتواند انتخاب شما را بین جو بایدن و دونالد ترامپ تغییر دهد). صنعت مبارزات انتخاباتی چند میلیارد دلاری در آمریکا که از انسان برای متقاعد کردن رأیدهندگان استفاده میکند، تنها میتواند تغییرات جزئی در رفتار آنها ایجاد کند.

ابزارهایی که میتوانند دست به تولید تصاویر و متون جعلی قابل باور بزنند، برای چندین و چند دهه متوالی وجود داشتهاند. اگرچه هوش مصنوعی ممکن است یک تکنولوژی در راستای صرفهجویی در کار مزارع ترولهای اینترنتی به شمار آید، اما مشخص نیست که آیا تلاش اصلی آن برای تولید اطلاعات نادرست باشد. الگوریتمهای جدید تصویرساز تواناییهای چشمگیری دارند، اما بدون تنظیم و قضاوت انسان، همچنان مستعد تولید تصاویری بیدقت- و افرادی با شش انگشت در هر دست- هستند.

حتی اگر این تاکتیکهای تقویتشده هوش مصنوعی مؤثر واقع شوند، به زودی توسط بسیاری از طرفین ذینفع پذیرفته میشوند: اثر تجمعی این عملیات نفوذ شبکههای اجتماعی را حتی غیرقابل استفادهتر خواهد کرد. در این میان اثبات اینکه میتوان بیاعتمادی را به یک مزیت سیستماتیک برای یکی از طرفین تبدیل کرد، دشوار است.

شرکتهای هوش مصنوعی و پلتفرمهای رسانههای اجتماعی که اطلاعات نادرست منتشر میکنند، میگویند که بر روی خطرات و ریسکهای موجود متمرکز شدهاند. اوپنایآی به عنوان شرکت پشتیبان چتجیپیتی میگوید که استفاده از این امکان را برای شناسایی عملیاتهای نفوذ سیاسی مورد نظارت قرار خواهد داد. پلتفرمهای بیگتک هم که به دلیل انتشار اطلاعات نادرست در انتخابات ۲۰۱۶ و البته حذف بیش از حد در سال ۲۰۲۰ مورد انتقاد قرار دارند، در شناسایی حسابهای مشکوک بهبود یافتهاند (اگرچه برای داوری در مورد صحت محتوای تولید شده توسط افراد واقعی دچار تنبلی هستند). آلفابت و متا استفاده از رسانههای دستکاریشده در تبلیغات سیاسی را ممنوع کرده و میگویند که به سرعت به تصاویر دیپفیک پاسخ خواهند داد. شرکتهای دیگر نیز در تلاش هستند تا استانداردی تکنولوژیکی برای تعیین منشأ تصاویر و ویدیوهای واقعی ایجاد کنند.

با این حال، تنظیم و کنترل داوطلبانه محدودیتهایی دارد و خطراتی را به همراه خواهد داشت. مدلهای متا که متن تولید میکنند و مدلهایی مانند استیبلدیفیوژن که تصویر میسازد، این قابلیت را دارند که بدون نظارت مورد استفاده قرار گیرند؛ و در این میان همه پلتفرمها نیز یکسان ایجاد نمیشوند. تیکتاک یکی از رسانههای اجتماعی اشتراکگذاری ویدیو است، با دولت چین ارتباط دارد و این برنامه برای ترویج ویروسپذیری از هر منبعی از جمله حسابهای جدید طراحی شده است. توییتر (که اکنون ایکس نامیده میشود) پس از خرید توسط ایلان ماسک تیم نظارتی خود را کاهش داده و این هم این پلتفرم را تبدیل به بهشتی برای رباتها کرده است. آژانس رگولاتوری انتخابات در آمریکا در حال بررسی یک الزام برای افشای کمپینهایی است که از تصاویر تولیدشده مصنوعی استفاده میکنند. روشی معقول- اگرچه بازیگران بدخواه از آن پیروی نمیکنند!

منبع:شفقنا